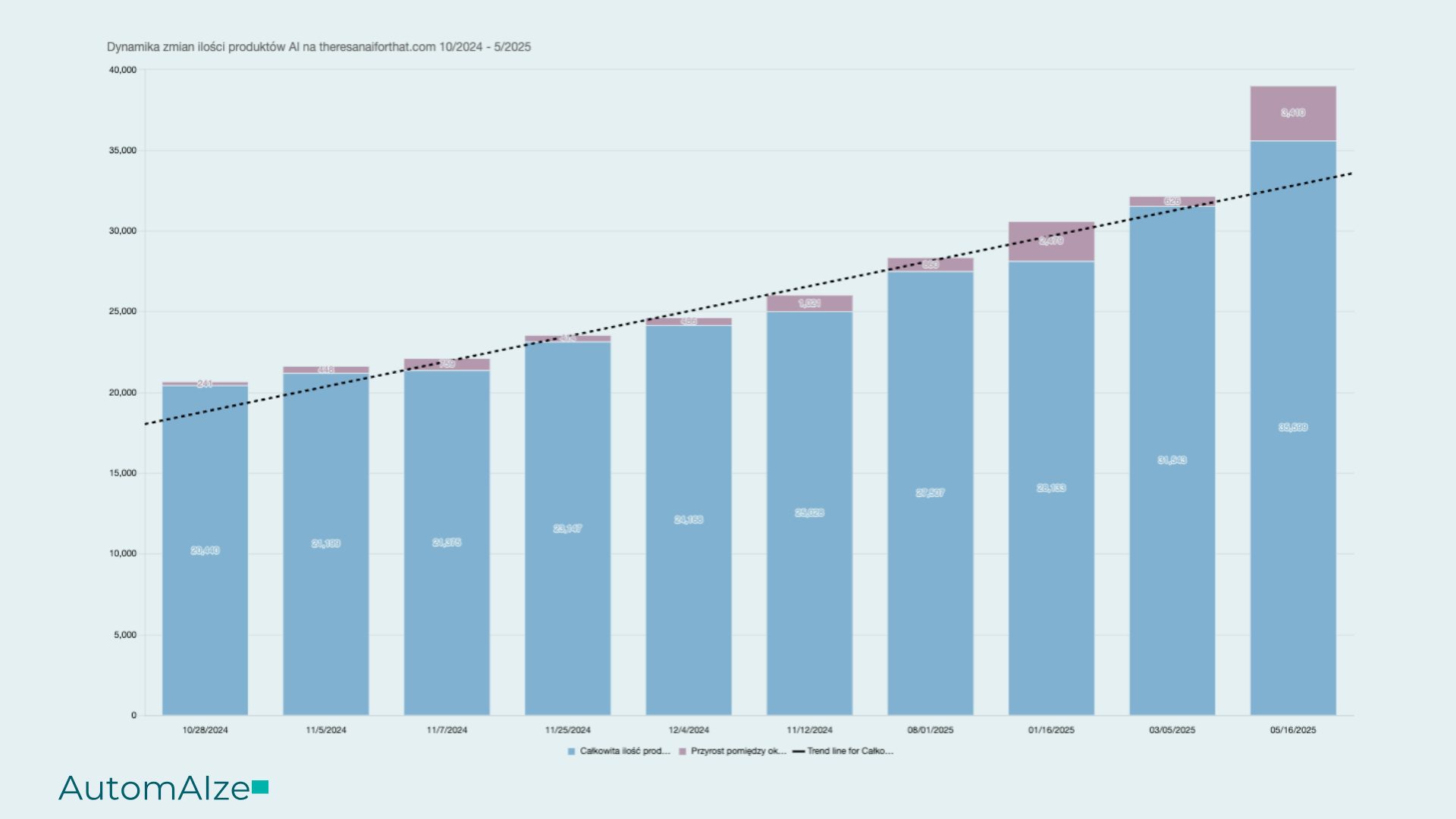

W dobie, gdzie większość wiodących produktów AI powstaje w USA, dziennie na rynek wychodzi około 100 oraz mamy naprawdę ograniczoną możliwość kontroli tych produktów - ryzyk jest naprawdę dużo - dane, finansowe czy reputacyjne.

Odpowiedzią na te wyzwania jest Polityka AI. W tym artykule dowiesz się:

- Czym jest Polityka AI i dlaczego warto ją mieć

- Jakie są główne obszary, na których się skupić

- Jak rozpocząć wdrożenie polityki krok po kroku

- Z jakich narzędzi i standardów korzystać

Czym jest Polityka AI?

Polityka AI to dokument firmowy określający:

- jak można używać AI,

- jakich narzędzi wolno używać,

- jakie są procedury reagowania na incydenty i ryzyka.

Pełni funkcję przewodnika po odpowiedzialnym, zgodnym z regulacjami i bezpiecznym wykorzystaniu AI. Główne cele polityki AI:

- Ochrona danych i prywatności (zgodność z GDPR, ISO-42001)

- Transparentność w działaniach (np. oznaczenia AI-generated content)

- Zarządzanie ryzykiem i incydentami

- Budowa zaufania wobec klientów, partnerów i pracowników

Polityka AI jest kluczowa dla organizacji wdrażających AI, ponieważ pomaga budować zaufanie pracowników, klientów, partnerów biznesowych i społeczeństwa. Firmy wdrażają też polityki AI, aby być zgodne z regulacjami takimi jak EU AI Act, NIST AI Risk Framework, ISO-42001, ISO-23984, Responsible AI institute czy ISO-5338.

Jest ona niezwykle ważna, jeżeli chodzi o wykorzystanie produktów AI oraz ograniczenie ich dostępności.

Przejdźmy do krytycznych obszarów polityki oraz omówmy jakie proponowane jeszcze są przez wymienione standardy. Skupimy się głównie na perspektywie organizacji, która jest konsumentem AI, czyli używa gotowe produkty na rynku.

Główne obszary w dokumencie Polityka AI

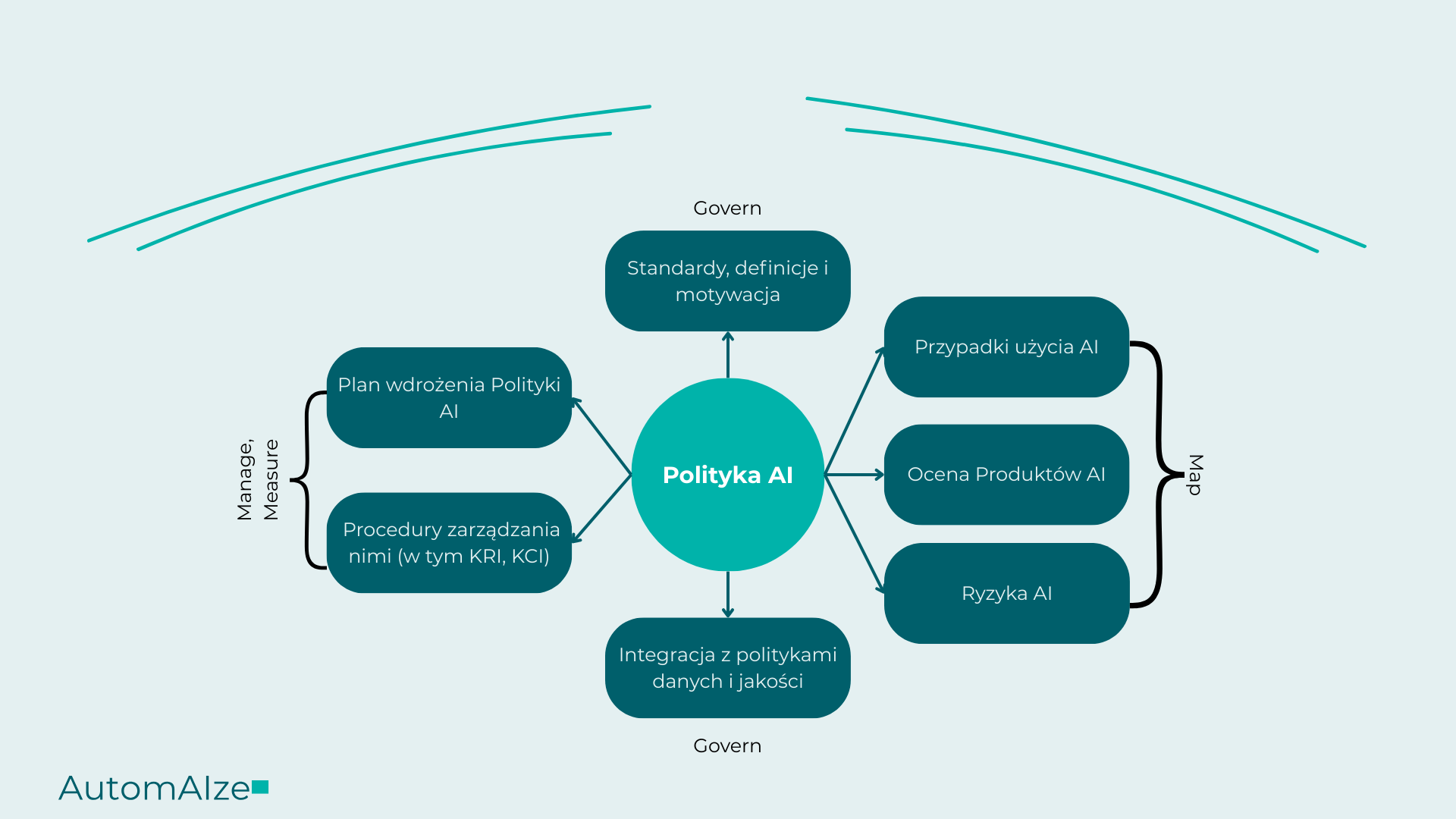

Govern - Map - Measure - Manage

Responsible AI institute wymienia 14 kluczowych elementów polityki AI, takich jak: uzasadnienie, zakres, zasady, cele i strategia, ład korporacyjny, zarządzanie danymi i ryzykiem, zarządzanie projektami, interesariuszami i pracownikami, zgodność z regulacjami, proces zakupowy, dokumentacja oraz egzekwowanie polityki.

Aby uprościć wdrożenie, polecamy podejście NIST AI RMF (Govern – Map – Measure – Manage), które stosujemy również w naszych projektach:

1. Govern – nadzór i odpowiedzialność

- Powołanie AI Committee

- Wyznaczenie właściciela polityki (np. CTO, Quality Leader)

- Spis ról i odpowiedzialności

2. Map – identyfikacja użycia AI

- Lista produktów AI używanych w firmie

- Ocena przypadków użycia (use cases)

- Klasyfikacja wg EU AI Act (wysokie, ograniczone, niedozwolone ryzyko)

3. Measure – pomiar i monitorowanie

- Definicja KRI (Key Risk Indicators) i KCI (Key Control Indicators)

- Procedury reagowania na incydenty

- Audyt zgodności i raportowanie

4. Manage – zarządzanie i egzekwowanie

- Procedury zarządzania ryzykiem

- Integracja z polityką prywatności i data governance

- Szkolenia pracowników (np. eLearning)

Taką politykę można rozszerzać o wymagania standardów regulacyjnych oraz własne potrzeby - pamiętajmy o praktyczności jego zastosowania.

Polityka AI:

Podejście

"Minimalna kontrola, maksymalna wartość"

Dostępność produktów AI jest praktycznie nieskończona. Jak podkreślaliśmy w artykule "Jak zacząć wdrożenie AI w firmie w 2025?" dziennie powstaje około 100 produktów, które są dostępne za darmo / w formie subskrypcji. Taka sytuacja wystawia organizację na duże ryzyko wykorzystania nieodpowiednich informacji w nieodpowiednim systemie, na przykład danych osobowych w niezabezpieczonym produkcie AI lub wysłania wrażliwego kodu oprogramowania, które następnie będzie dostępne dla innych użytkowników. Więcej omówimy w kolejnej sekcji lecz z perspektywy pracowników wewnątrz firmy najważniejsze jest, aby:

- Wiedzieli, jakie produkty są dozwolone w firmie

- Jakie produkty są zakazane

- Jak każdy pracownik bierze odpowiedzialność za predykcje / rezultaty / treści wygenerowane w AI

- Czy w firmie podejmowane są automatyczne decyzje

- Gdzie kierować się, gdy dojdzie do wykroczenia poza zasady polityki

- Kto odpowiada za politykę AI

- Mechanizmy kontroli i monitorowania w firmie

- Zgodność z regulacjami (jeżeli jest jakakolwiek)

- Procedura reagowania na incydenty

Takie podstawowe wytyczne oraz zasady pozwalają na odnalezienie się zainteresowanym w działaniu. Warto posiłkować się też dostępnymi na rynku zasadami Responsible AI principles od firm takich jak Microsoft, AWS, Google czy OECD.

Polityka AI: Govern

Skuteczne zarządzanie AI zaczyna się od przypisania odpowiedzialności. W firmie warto powołać komitet AI (AI Committee), który ocenia produkty, zatwierdza przypadki użycia i reaguje na incydenty. Za całość powinien odpowiadać konkretny właściciel polityki AI – np. CTO, dyrektor jakości lub compliance officer.

Polityka AI powinna jasno wskazywać, kto może używać AI i na jakich zasadach. Pracownicy muszą wiedzieć, że każda predykcja AI wymaga ludzkiej weryfikacji, a pełna automatyzacja decyzji nie jest dopuszczalna bez wyjątkowych zabezpieczeń.

Dane to krytyczny zasób. W polityce należy określić, które źródła danych mogą być używane z AI (np. dane publiczne, dane klientów, dane z systemów ERP) i jakie obowiązują ograniczenia (np. brak przetwarzania PII w narzędziach chmurowych). Dobre zarządzanie zaczyna się od jasnych zasad dostępu i wykorzystania informacji.

Polityka AI: Map

Drugi filar to mapowanie użycia AI w firmie. Bez tego trudno mówić o zarządzaniu – nie wiesz, gdzie są ryzyka, kto używa AI i czy robi to zgodnie z polityką.

Przypadki użycia AI (use cases)

Zacznij od stworzenia listy zastosowań AI w firmie: czy to wsparcie HR w rekrutacji, automatyzacja ofert handlowych, czy asystenci kodu w IT. Dla każdego przypadku określ:

- kto używa AI i w jakim celu,

- jakie dane są przetwarzane,

- czy istnieje ryzyko automatycznego podejmowania decyzji.

Ocena produktów AI

Nie wszystkie narzędzia są bezpieczne. Mapuj używane produkty (np. Microsoft Copilot, Perplexity czy ChatGPT) i sprawdzaj:

-

kontrola nad danymi w produkcie

- czy można podpisać DPA - umowę powierzenia danych

- czy produkt przechowuje dane w UE

- jakie certyfikaty bezpieczeństwa posiada produkt AI

Ryzyka AI

Dla każdego przypadku użycia AI, zdefiniuj ryzyka. Zakwalifikuj też te przypadki według EU AI Act:

- zakazane (np. ocena społeczna, rozpoznawanie twarzy)

- wysokie (np. AI w rekrutacji, ocenie pracowników),

- ograniczone (np. AI w marketingu),

- niskie (np. AI do streszczeń wewnętrznych spotkań).

To fundament do dalszych działań z zakresu zarządzania i kontroli.

Polityka AI:

Measure

Trzeci filar to monitorowanie – bo nawet najlepsze zasady nic nie znaczą, jeśli nie wiesz, czy są przestrzegane. W tym celu warto wdrożyć konkretne wskaźniki i system reagowania.

KRI – Key Risk Indicators

Wskaźniki ryzyka pozwalają przewidywać zagrożenia. Przykłady:

- % pracowników używających niezatwierdzonych narzędzi AI,

- liczba incydentów z udziałem danych w produktach AI,

- liczba przypadków użycia AI bez weryfikacji przez człowieka.

KCI – Key Control Indicators

Wskaźniki kontroli pokazują, czy organizacja działa zgodnie z polityką. Przykłady:

- % przypadków AI z oznaczeniem „wygenerowano przez AI”,

- % pracowników przeszkolonych z Polityki AI,

- % zatwierdzonych narzędzi AI z podpisanym DPA.

Monitorowanie incydentów

Każdy incydent z AI (np. wysłanie danych do ChatGPT, halucynacje w dokumentacji, błędne predykcje) musi być:

- zgłoszony (np. mailowo lub przez formularz),

- zarejestrowany w systemie incydentów,

- przeanalizowany i skategoryzowany (np. reputacyjne, finansowe, zgodność z ISO-9001/13485).

Warto przygotować też prosty plan reagowania – kto co robi i w jakim czasie, np. 48h na kontakt z klientem, 24h na zgłoszenie do zespołu AI.

Polityka AI: Manage

Ostatni filar to działanie – czyli jak wdrożyć Politykę AI w praktyce i upewnić się, że nie zostanie tylko „na papierze”.

Procedury zarządzania ryzykiem

Organizacja powinna wdrożyć proces oceny i akceptacji nowych przypadków użycia AI – najlepiej w formie cyklicznych spotkań zespołu AI Committee.

Dla każdego nowego narzędzia lub przypadku należy:

- ocenić ryzyko (zgodnie z EU AI Act),

- zatwierdzić lub odrzucić wdrożenie,

- określić sposób monitorowania,

- zastosować metody prewencyjne do ryzyk

Równolegle – firma powinna utrzymywać listę „dozwolonych” i „zakazanych” narzędzi AI, zgodnie z polityką prywatności i zasadami wewnętrznymi.

Plan egzekucji polityki AI

Polityka AI musi mieć plan wdrożenia. W praktyce to oznacza:

- Szkolenie wszystkich pracowników (np. w formie e-learningu)

- Wdrożenie mechanizmów technicznych: ograniczenie dostępu do niezatwierdzonych narzędzi, logowanie użycia AI, tagowanie treści wygenerowanych przez AI

- Regularny przegląd i aktualizacja polityki (np. raz na 6 miesięcy)

Dobrze działająca polityka AI to taka, którą zna i stosuje każdy pracownik – od działu sprzedaży po R&D.

Co daje Polityka AI w Firmie?

Wdrożenie Polityki AI to realna wartość – nie tylko formalna zgodność z regulacjami, ale też konkretne usprawnienia organizacyjne:

✅ Jasne role i odpowiedzialności – w firmie wiadomo, kto odpowiada za ocenę, wdrażanie i kontrolę AI (AI Committee, właściciel polityki)

✅ Świadomość ryzyk – organizacja zna zagrożenia związane z AI, potrafi je monitorować i minimalizować

✅ Bezpieczne wdrożenia – produkty takie jak asystenci kodu, narzędzia do generowania treści czy chatboty są stosowane zgodnie z polityką i regulacjami (np. EU AI Act)

✅ Gotowość na incydenty – zespół wie, jak reagować na naruszenia, halucynacje, błędne predykcje czy problemy z przetwarzaniem danych

✅ Wzrost zaufania – wśród klientów, partnerów i pracowników, że firma stosuje AI odpowiedzialnie i transparentnie

Dla kogo jest Polityka AI?

Rozpocząć może każda firma, ale szczególnie rekomendujemy ją dla organizacji, które:

- używają więcej niż jednego narzędzia AI w pracy codziennej

- działają w sektorze regulowanym (np. medtech, fintech, HR)

- planują rozwijać własne modele AI lub systemy decyzyjne

- przetwarzają dane osobowe, wrażliwe lub własność intelektualną klientów

- chcą kontrolować produktywność i bezpieczeństwo w pracy z AI

Główne pytania dotyczące Polityki AI w firmie

🔹 ISO/IEC 42001 (AI Management System)

🔹 NIST AI Risk Management Framework

🔹 EU AI Act + Compliance Checker

🔹 Responsible AI Institute (szablon polityki i zasady)

Skontaktuj się z nami tutaj, a wyślemy Ci szablon.

Polityki prywatności, Warunki użycia, "Trust centers" czy dokumentacje produktów.

Podsumowanie: czy warto wdrażać Politykę AI w firmie?

W świecie, gdzie każdego dnia pojawiają się dziesiątki nowych narzędzi AI, a regulacje rosną szybciej niż możliwości technologii – brak jasnych zasad to realne ryzyko.

Polityka AI to sposób, by uporządkować chaos. Pomaga zdefiniować, z jakich narzędzi mogą korzystać Twoi pracownicy, kto ponosi odpowiedzialność za ich działanie i jak reagować, gdy coś pójdzie nie tak.

Dzięki polityce Twoja firma chroni dane, działa zgodnie z przepisami i może bezpiecznie skalować wdrożenia AI. Co równie ważne – budujesz zaufanie: klientów, partnerów i zespołu. W 2025 roku to nie luksus. To konieczność.

Jeśli chcesz wdrażać AI bezpiecznie – zacznij od polityki AI.

To pierwszy krok do odpowiedzialnego, skutecznego i zrównoważonego wykorzystania sztucznej inteligencji w Twojej organizacji.

Poszukujesz Politykę AI dla Twojej firmy?

Zamów bezpłatną konsultację już teraz!